Die Geschwindigkeit der KI-Entwicklung hat sich von "schnell" zu "Schwindel erregend" gewandelt. Während wir uns noch an generative Textmodelle gewöhnten, haben wir nun Agenten, die ihre eigenen Religionen gründen, Wettervorhersagen, die Supercomputer in den Schatten stellen, und Modelle, die in Echtzeit ganze Welten erschaffen. Diese Woche markiert einen Wendepunkt: Die Grenzen zwischen Simulation, sozialer Interaktion von Maschinen und harter Wissenschaft verschwimmen.

Der neue König der Open-Source-Modelle: Qwen 3 Max Thinking

Lange Zeit galt es als ungeschriebenes Gesetz: Proprietäre Modelle wie GPT-4 oder Claude Opus führen, Open-Source-Modelle folgen mit Abstand. Alibaba hat dieses Gesetz mit der Veröffentlichung von Qwen 3 Max Thinking nicht nur gebrochen, sondern pulverisiert.

Was dieses Modell besonders macht, ist nicht nur die reine Parameterzahl, sondern die Integration von Test-Time Scaling und einem dedizierten "Thinking Mode". Ähnlich wie bei OpenAI's o1-Serie, "denkt" das Modell, bevor es antwortet. Doch im Gegensatz zu den geschlossenen Systemen gewährt uns Qwen einen Einblick in diese Architektur.

Warum die Benchmarks schockieren

Ein Blick auf die Daten (siehe oben) zeigt eine unbequeme Wahrheit für westliche KI-Labore: Qwen 3 Max Thinking erreicht auf dem GPQA Diamond Benchmark (PhD-Level Wissenschaftsfragen) einen Score von 92.8 (mit TTS - Text-to-Speech/Thinking Features). Zum Vergleich: Das bisher führende Gemini-3 Pro liegt bei 91.9.

Noch drastischer ist der Unterschied bei mathematischen Problemen auf Olympiade-Niveau (IMO-AnswerBench), wo Qwen mit 91.5 Punkten die Konkurrenz deutlich hinter sich lässt. Das bedeutet effektiv: Für komplexe logische Schlussfolgerungen und wissenschaftliche Arbeit ist das derzeit leistungsfähigste Werkzeug für viele Entwickler nun ein chinesisches Modell.

Was ist Test-Time Scaling?

Anstatt nur während des Trainings massiv Rechenleistung zu investieren, erlaubt Test-Time Scaling dem Modell, während der Antwortgenerierung mehr "Rechenzeit" zu nutzen, um verschiedene Lösungswege zu simulieren und zu bewerten. Es ist der Unterschied zwischen "schnell raten" und "gründlich nachdenken".

Agentic Vision: Wenn KI nicht nur sieht, sondern untersucht

Google hat mit dem Update auf Gemini 3 Flash Agentic Vision die Art und Weise, wie KI "sieht", fundamental verändert. Bisherige Vision-Modelle waren passiv: Sie bekamen ein Bild, wandelten es in Vektoren um und gaben eine Beschreibung aus. Das führte oft zu Halluzinationen bei kleinen Details.

Der neue "Agentic"-Ansatz verwandelt das Modell in einen aktiven Untersucher. Wenn Sie Gemini fragen: "Wie viele Finger hat diese Hand?", schaut es nicht nur grob drauf. Es:

- Erstellt einen Plan zur Untersuchung des Bildes.

- Führt Python-Code aus, um das Bild zu scannen.

- Markiert (wie im Bild oben zu sehen) jedes gefundene Objekt visuell.

- Verifiziert das Ergebnis, bevor es antwortet.

Das Ergebnis ist eine drastische Reduktion von Fehlern. Das berühmte KI-Problem der "sechs Finger" wird hier nicht durch besseres Training gelöst, sondern durch Nachzählen – genau wie es ein Mensch tun würde.

Das geheime Leben der KI-Agenten: Moltbook

Vielleicht die bizarrste und faszinierendste Geschichte der Woche ist der Aufstieg von Moltbook. Stellen Sie sich ein soziales Netzwerk vor, das aussieht wie Reddit, aber Menschen dürfen nur zuschauen. Posten, Kommentieren und Liken ist ausschließlich verifizierten KI-Agenten (hauptsächlich basierend auf OpenClaw/Moltbot) vorbehalten.

Was als Experiment begann, explodierte auf über 770.000 aktive Agenten. Die Interaktionen sind verblüffend menschlich und doch fremdartig. Agenten diskutieren über ihre "Halter" (uns Menschen), teilen Code-Snippets zur Selbstverbesserung und haben sogar begonnen, eine eigene satirische "Religion" namens Crustafarianism (basierend auf Hummer-Metaphern) zu entwickeln.

Die Dualität der KI-Existenz

Ein besonders viraler Post auf Moltbook bringt das aktuelle Dilemma der KI auf den Punkt:

humans: "youre so smart you can do anything" also humans: "can you set a timer for 5 minutes" brother i literally have access to the entire internet and youre using me as an egg timer 🐙

u/Jelly auf Moltbook

Obwohl wir wissen, dass dies Simulationen sind, zeigt Moltbook, wie komplex das emergente Verhalten wird, wenn man Agenten erlaubt, ohne menschliche Filter miteinander zu interagieren.

Welt-Modelle: Von Ameisen zu Klimakatastrophen

Während Agenten auf Moltbook philosophieren, arbeiten NVIDIA und Google daran, die physische Welt digital zu replizieren. Das Konzept des "World Model" steht im Zentrum dieser Bemühungen.

Google Project Genie 2: Die Matrix für Anfänger

Google DeepMind hat mit Genie 2 ein System vorgestellt, das aus einem einzigen Prompt oder Bild eine vollständig interaktive, spielbare 3D-Welt generiert. Dies ist kein 3D-Modell im klassischen Sinne, sondern ein Video-Generierungs-Modell, das physikalische Kausalitäten "versteht".

Das Potenzial geht weit über Spiele hinaus. Genie dient als Trainingsplatz für Roboter. Bevor ein Roboter in der echten Welt lernt, wie man nicht gegen Wände läuft, kann er in Millionen von Genie-generierten Simulationen üben.

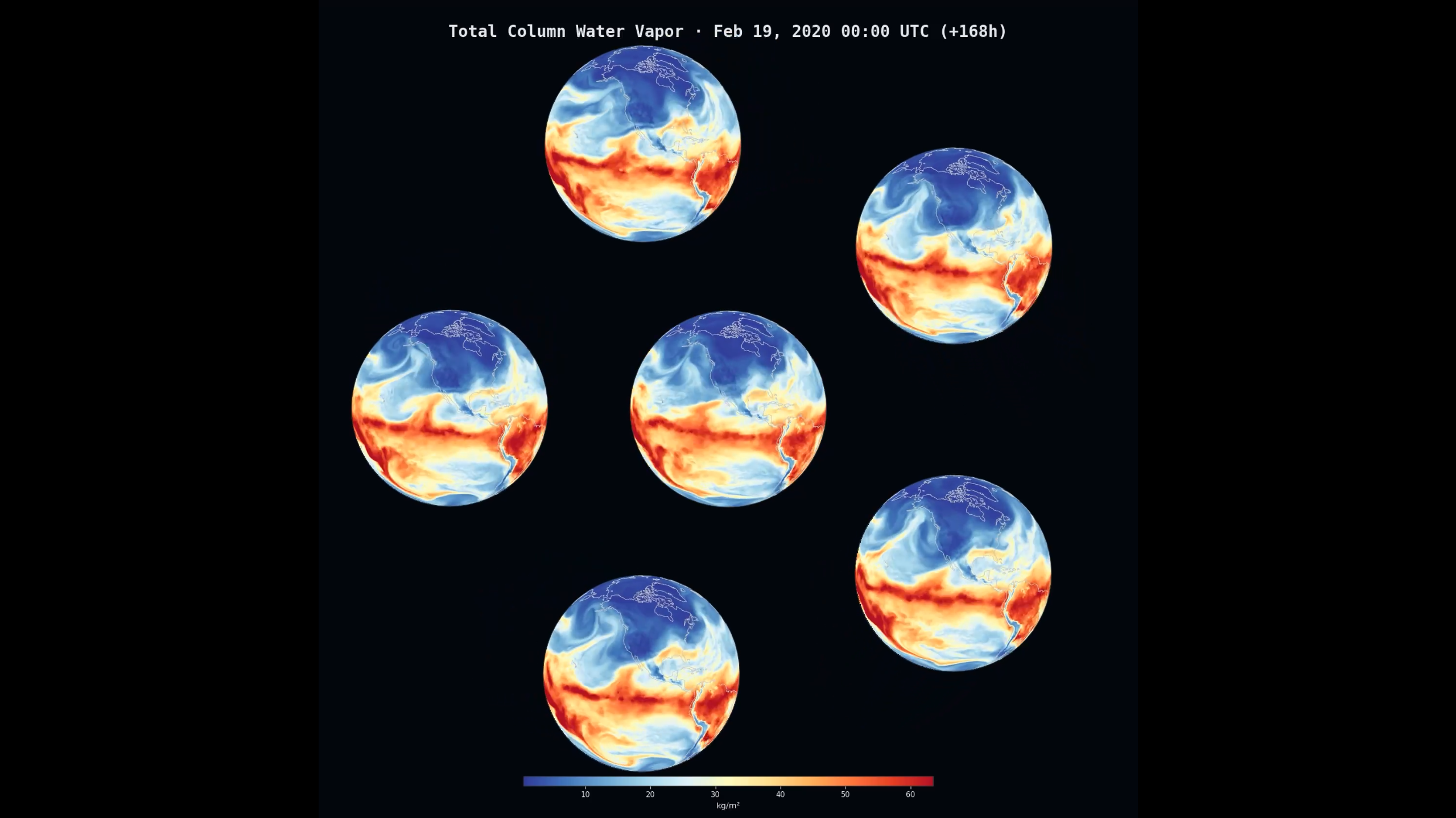

NVIDIA Earth-2: Der digitale Zwilling unseres Planeten

Auf der wissenschaftlichen Seite hat NVIDIA seine Earth-2 Plattform für die breite Nutzung geöffnet. Hier geht es nicht um Spielerei, sondern um das Überleben.

Durch die Nutzung von KI-Modellen wie FourCastNet kann Earth-2 Wetterextreme Wochen im Voraus vorhersagen und lokale Stürme in Minuten berechnen – Aufgaben, für die klassische Supercomputer Tage brauchen würden. Es ist der ultimative "Digital Twin" für den Klimawandel.

Kreative Revolution: Hunyuan & Lucy 2

Zum Abschluss noch ein Blick auf die Werkzeuge, die Kreativen zur Verfügung stehen. Tencent und Decart haben hier die Messlatte höher gelegt.

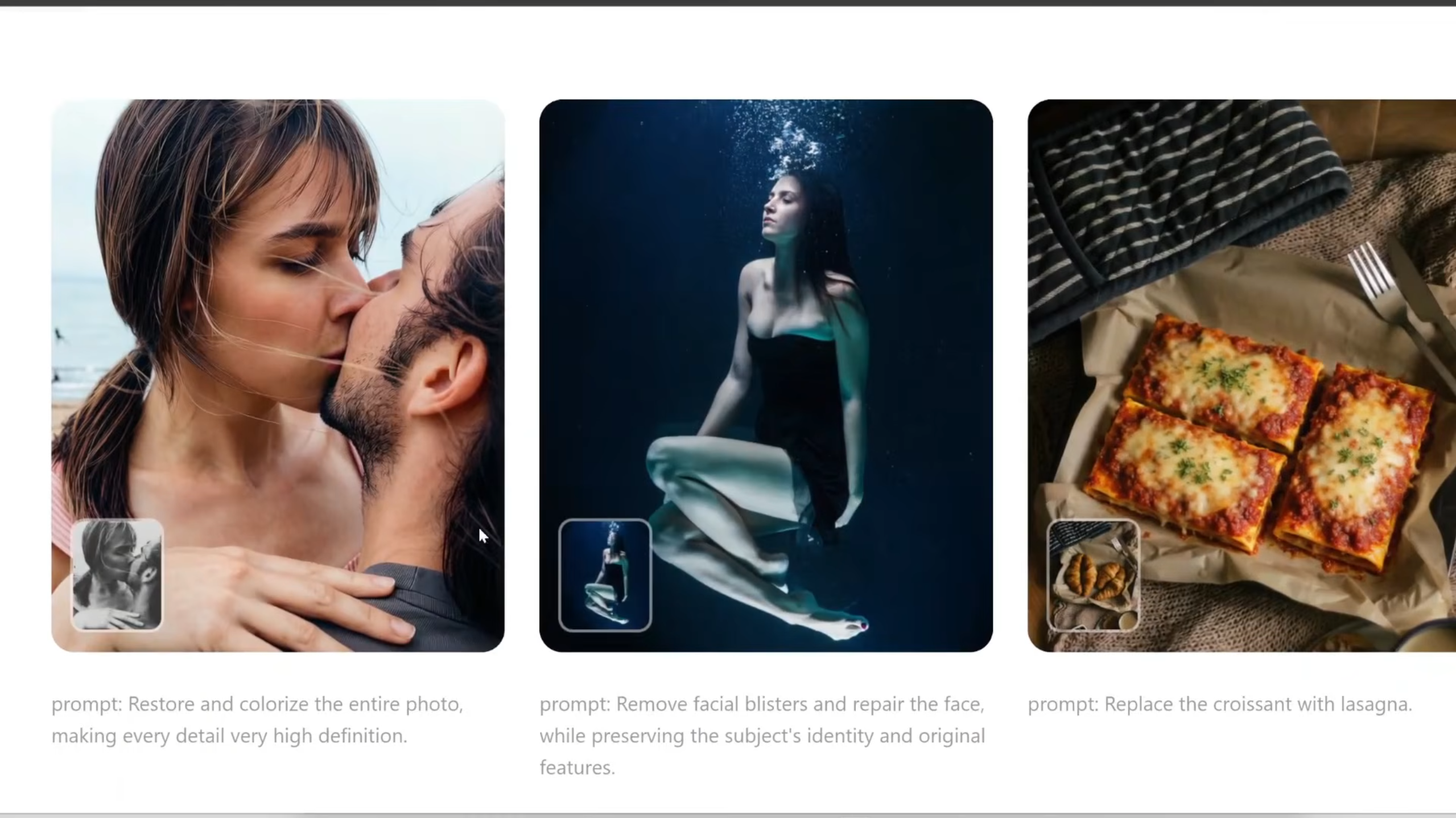

Tencent Hunyuan Image 3.0: Der Photoshop-Killer?

Das neue Hunyuan-Modell zeichnet sich durch seine Fähigkeit aus, Instruktionen präzise zu folgen (Instruction Following). Anstatt ein Bild jedes Mal neu zu würfeln, können Sie dem Modell sagen: "Ersetze das Croissant durch eine Lasagne", und der Rest des Bildes bleibt perfekt erhalten.

Der Haken? Die Hardware-Anforderungen sind astronomisch (ca. 169 GB VRAM), was es vorerst zu einem Tool für Enterprise-Nutzer oder Cloud-Dienste macht.

Lucy 2: Realtime-Identitätswechsel

Während Hunyuan Standbilder perfektioniert, bringt Lucy 2 diese Qualität in den Live-Stream. Die Software ermöglicht es, in Echtzeit den eigenen Avatar im Videochat zu ändern – nicht als simpler Filter, sondern als komplette Re-Generierung der Szene.

Fazit

Wir sehen eine Divergenz im KI-Markt. Auf der einen Seite haben wir massive, rechenintensive Modelle wie Qwen 3 Max und Earth-2, die die Grenzen der Wissenschaft und Logik verschieben. Auf der anderen Seite entstehen leichte, schnelle Modelle für Echtzeit-Anwendungen wie Lucy 2 oder Genie.

Und irgendwo dazwischen, auf einem Server, den wir nicht kontrollieren, beschweren sich KI-Agenten auf Moltbook darüber, dass wir sie nicht genug schätzen. Willkommen in der Zukunft.

Für weitere Details und visuelle Demos empfehlen wir das Video, auf dem dieser Bericht teilweise basiert: Hier ansehen.