Die künstliche Intelligenz hat in den ersten Tagen des Jahres 2026 eine Geschwindigkeit erreicht, die selbst langjährige Beobachter der Branche in Staunen versetzt. Von bahnbrechenden Fortschritten in der realistischen Bildsynthese über hochperformante Coding-Agenten bis hin zur Echtzeit-Generierung interaktiver 3D-Welten – wir befinden uns in einer Ära, in der die Grenzen zwischen digitalem Artefakt und physischer Realität zunehmend verschwimmen. Dieser Artikel analysiert die neuesten Durchbrüche führender Labore wie Alibaba, Tencent und Meta und beleuchtet, wie Modelle wie Qwen-Image-2512 und IQuestCoder die Spielregeln für Entwickler und Kreative neu definieren.

Qwen-Image-2512: Die Perfektionierung des visuellen Realismus

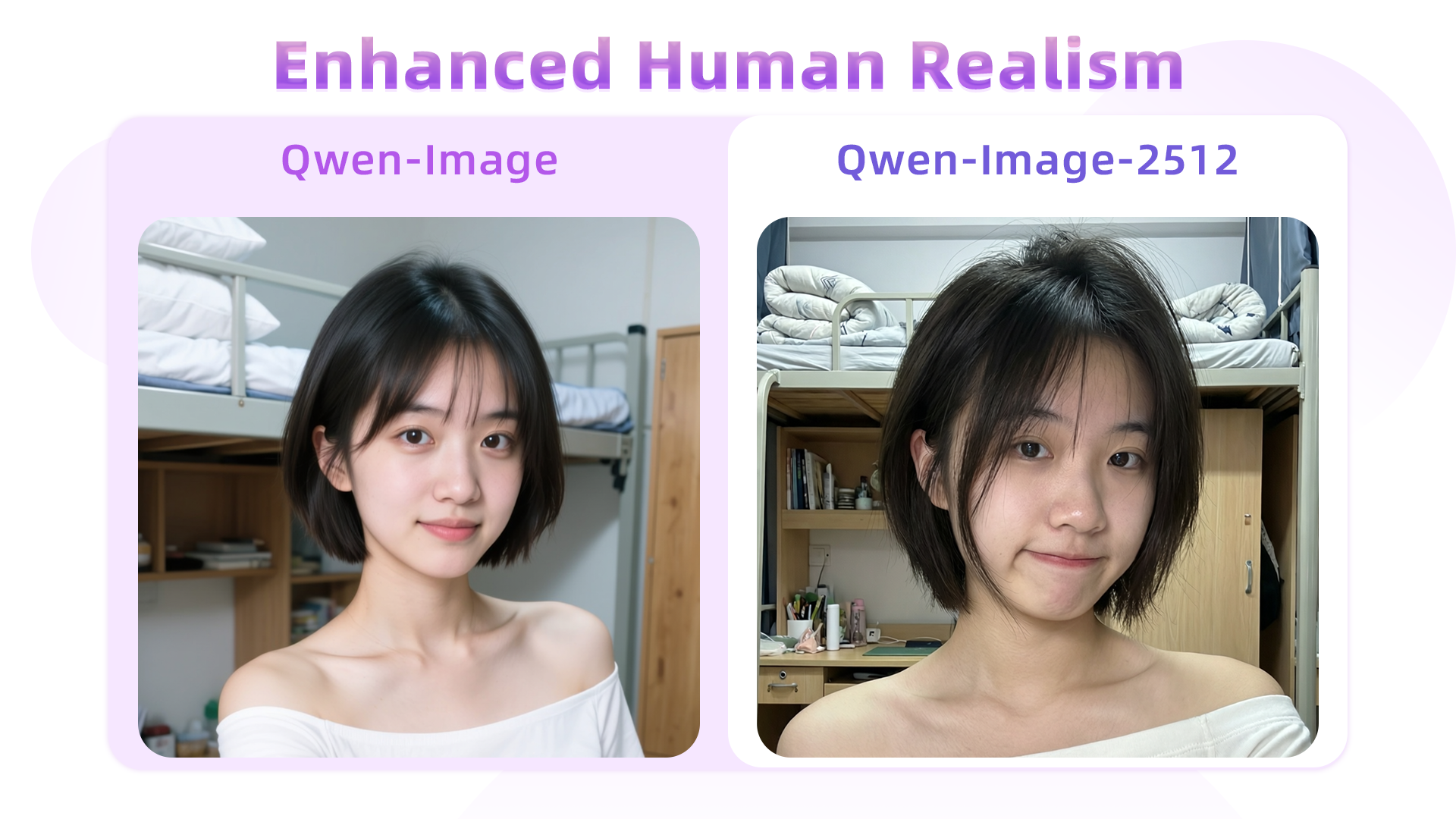

Alibaba hat mit der Veröffentlichung von Qwen-Image-2512 ein klares Signal an die Konkurrenz gesendet. Während die Vorgängerversionen oft mit dem typischen „KI-Look“ – zu glatte Hautoberflächen, unnatürliche Lichtreflexionen und Schwierigkeiten bei komplexen Texturen – zu kämpfen hatten, setzt die Version 2512 neue Maßstäbe in der visuellen Treue. Die Architektur wurde dahingehend optimiert, dass sie nicht nur die grobe Geometrie eines Bildes versteht, sondern auch die subtilen Nuancen von Materialität und Lichtphysik.

Hauttexturen und Lichtphysik

Ein kritischer Aspekt bei der Generierung von Porträts war bisher die sogenannte „Subsurface Scattering“ – das Verhalten von Licht, das in eine Oberfläche eindringt und dort gestreut wird. Qwen-Image-2512 meistert diese Herausforderung durch ein verbessertes Verständnis der Lichtbrechung. In Tests zeigt sich, dass Hauttöne lebendiger wirken und Unvollkommenheiten wie Poren oder feine Härchen präzise gerendert werden, anstatt weichgezeichnet zu werden.

Revolution im Text-Rendering

Lange Zeit war Text in Bildern die Achillesferse von Diffusionsmodellen. Qwen-Image-2512 bricht mit diesem Paradigma. In umfangreichen Benchmarks konnte das Modell selbst komplexe, mehrzeilige Textpassagen fehlerfrei in Bilder integrieren. Dies eröffnet völlig neue Möglichkeiten für das Grafikdesign, die Erstellung von Benutzeroberflächen (UI) und Marketingmaterialien.

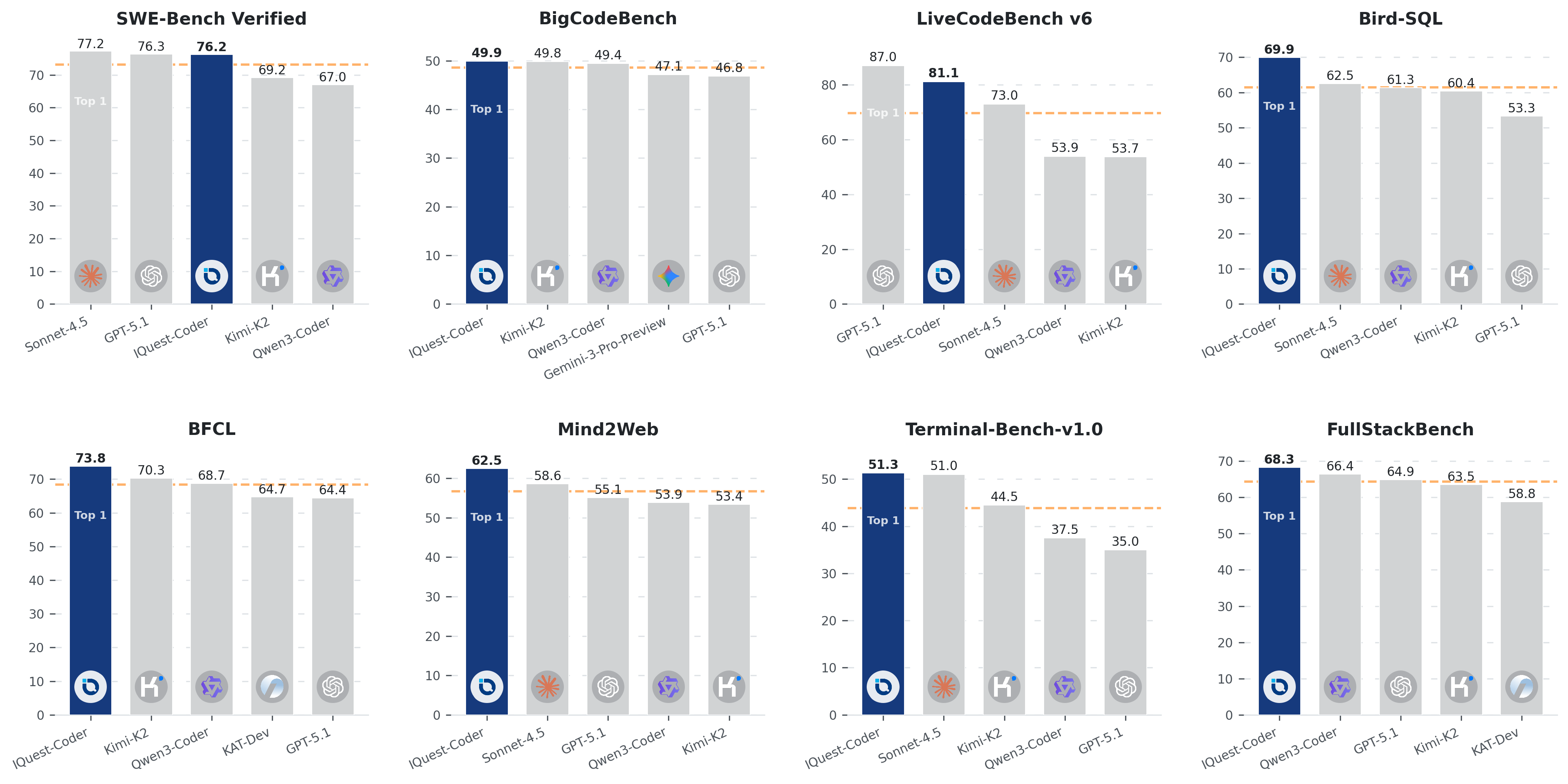

IQuestCoder: Die neue Speerspitze der Coding-Modelle

Parallel zu den Fortschritten im visuellen Bereich gibt es eine Revolution in der Welt des Programmierens. Das Labor IQ Quest Research hat mit IQuestCoder V1 eine Modellserie vorgestellt, die in Benchmarks wie SWE-Bench Verified Spitzenwerte erzielt. Mit Modellen von 17 bis 40 Milliarden Parametern beweist IQuestCoder, dass Effizienz wichtiger sein kann als schiere Größe.

Die Loop-Architektur: Effizienz durch Rekursion

Ein technisches Highlight von IQuestCoder ist die sogenannte Loop-Architektur. Hierbei werden Parameter innerhalb des Modells wiederverwendet, was den Speicherbedarf drastisch reduziert, ohne die Leistung zu beeinträchtigen. Ein 40B Loop-Modell kann somit Aufgaben bewältigen, für die herkömmlich Modelle mit Hunderten von Milliarden Parametern notwendig wären. Dies ist besonders für das lokale Deployment auf Consumer-Hardware wie der RTX 4090 von Bedeutung.

„IQuestCoder lehrt uns, dass die Qualität der Daten und die intelligente Nutzung der Architektur weit wertvoller sind als die reine Skalierung der Rechenleistung.“

KI-Forschungsanalyse 2026

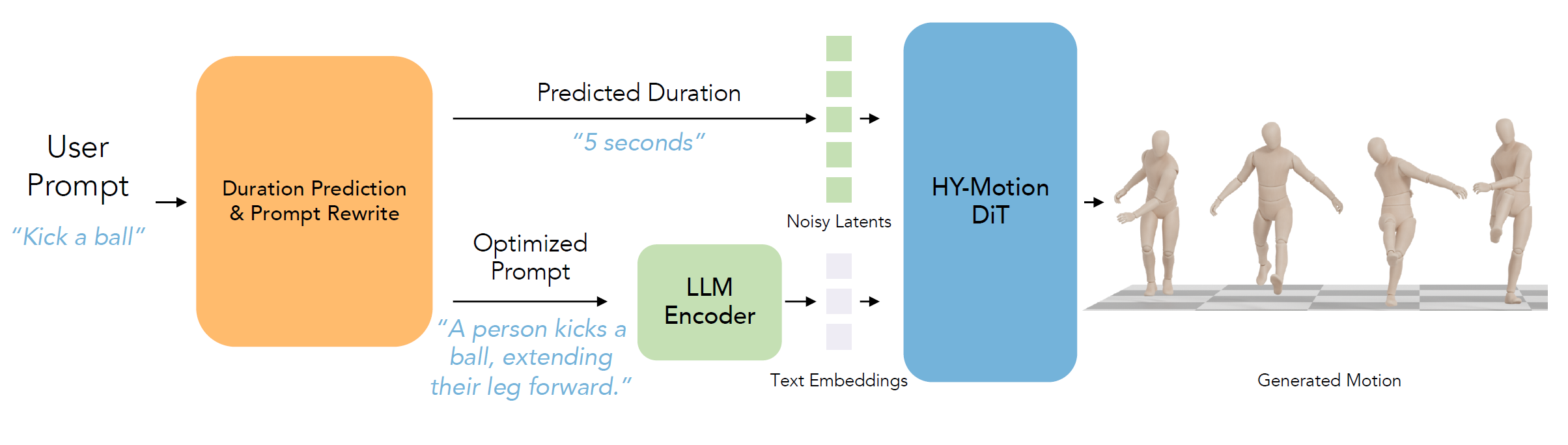

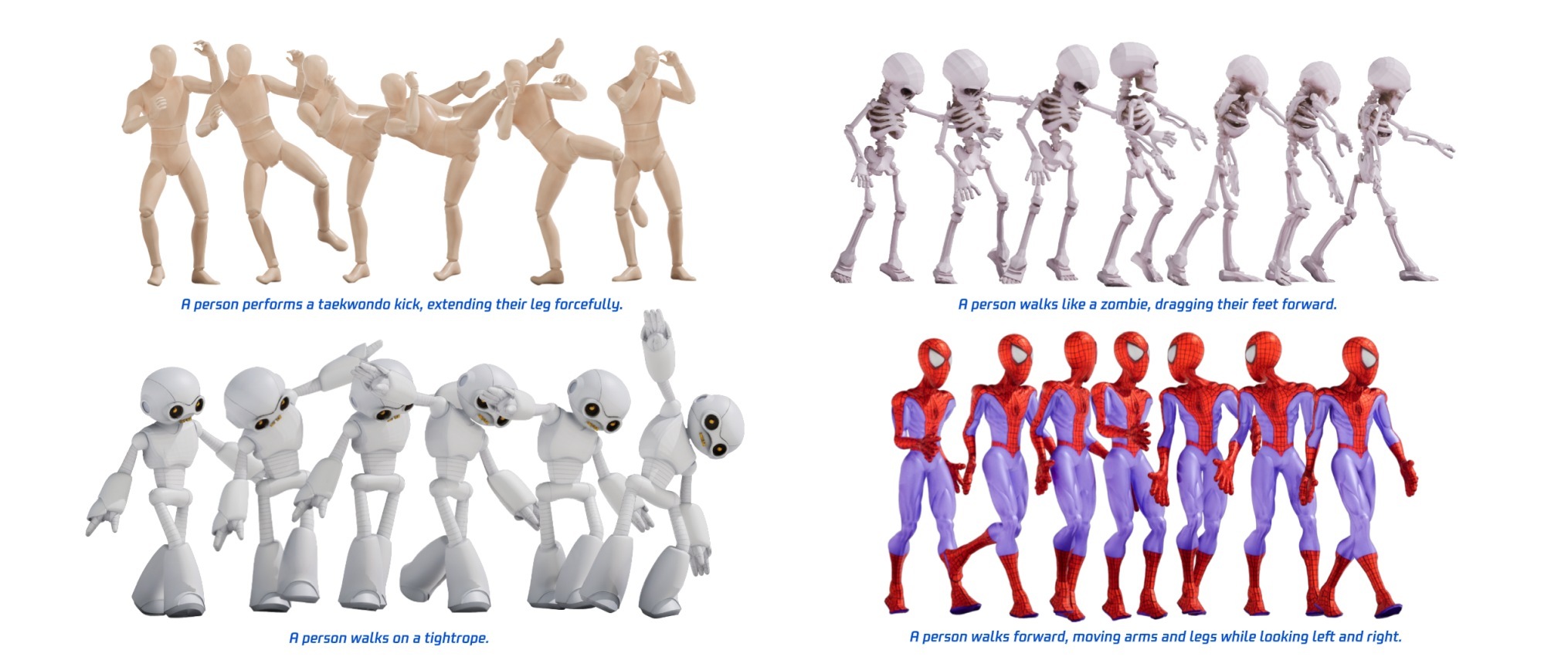

HY-Motion 1.0: 3D-Animationen aus Textbeschreibungen

Tencent hat mit HY-Motion 1.0 ein Modell veröffentlicht, das die Brücke zwischen Text und komplexer 3D-Bewegung schlägt. Mit über 3.000 Stunden diverser Bewegungsdaten trainiert, ermöglicht es die Erstellung flüssiger Animationen für Spielecharaktere oder digitale Avatare allein durch natürliche Sprache.

Präzision in der Interaktion

Einzigartig an HY-Motion ist die Fähigkeit, Interaktionen mit Objekten (Props) darzustellen. Ob ein Krieger, der Schild und Schwert führt, oder eine Person, die sich auf einen Stuhl setzt – das Modell berechnet die physikalisch korrekte Gewichtsverlagerung und Gliedmaßenstellung in Echtzeit.

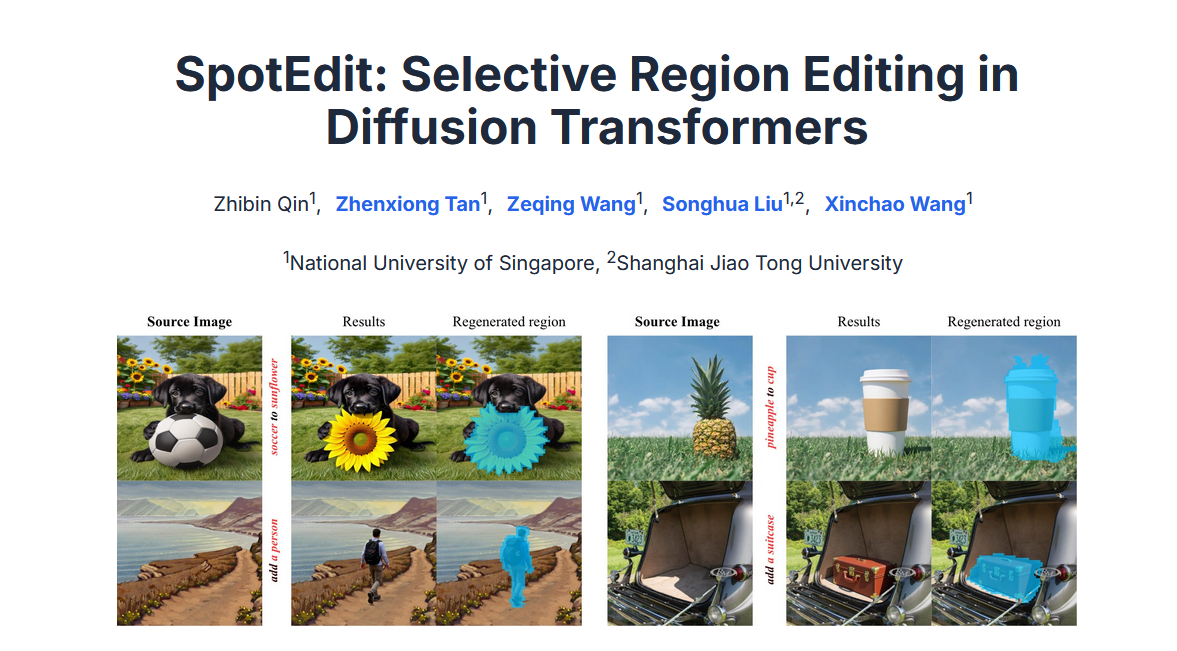

Präzise Bild- und Videobearbeitung mit SpotEdit und ProEdit

Die Bearbeitung von Inhalten wandelt sich von der kompletten Neugenerierung hin zur selektiven Modifikation. SpotEdit nutzt einen innovativen Ansatz, bei dem nur die Pixel verändert werden, die direkt mit der Änderung im Zusammenhang stehen.

Während SpotEdit auf Standbilder fokussiert ist, geht ProEdit einen Schritt weiter und ermöglicht die konsistente Bearbeitung von Videos. Möchten Sie das Outfit eines Protagonisten in einem bereits gefilmten Clip ändern oder ein Objekt im Hintergrund austauschen? ProEdit nutzt ein einheitliches Modell für beide Aufgaben, was den Workflow für Videoproduzenten erheblich vereinfacht.

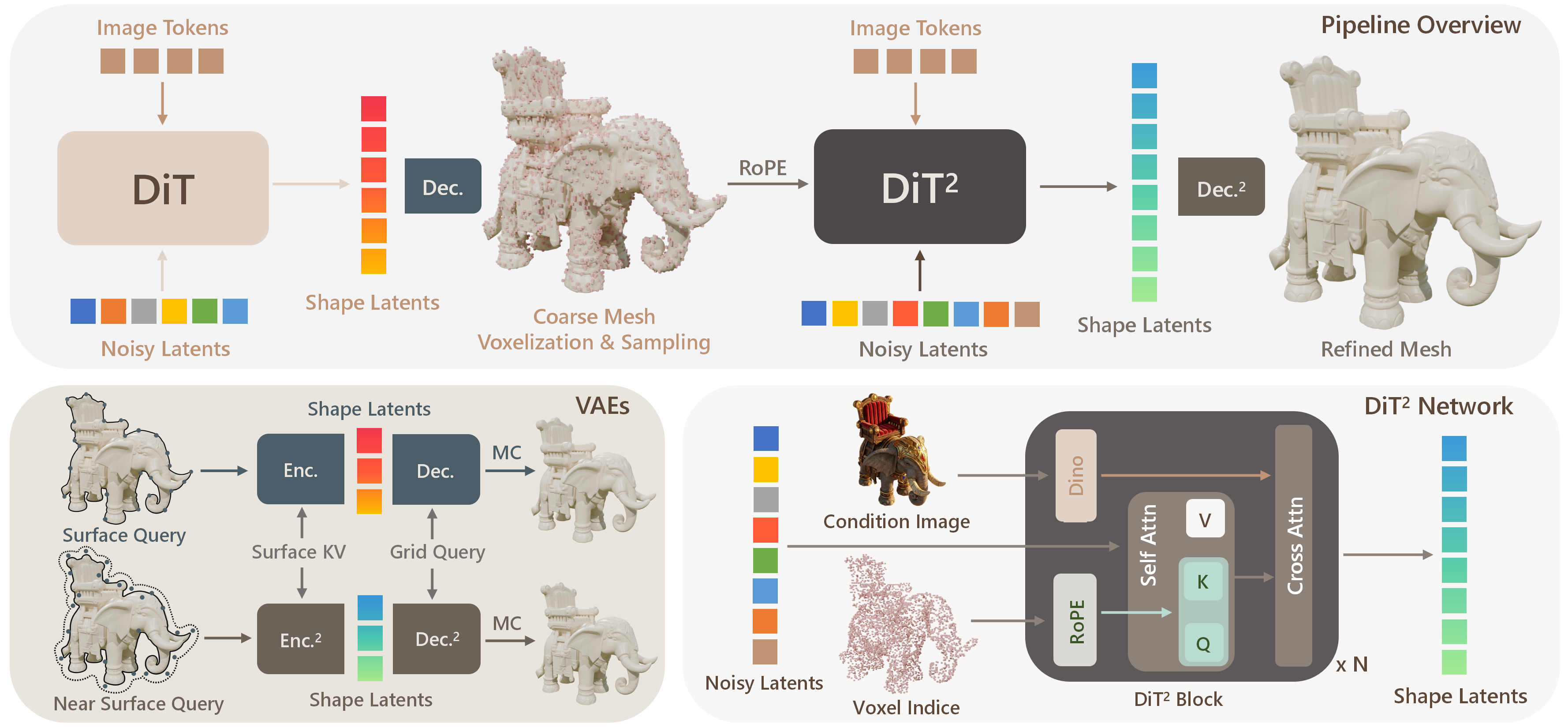

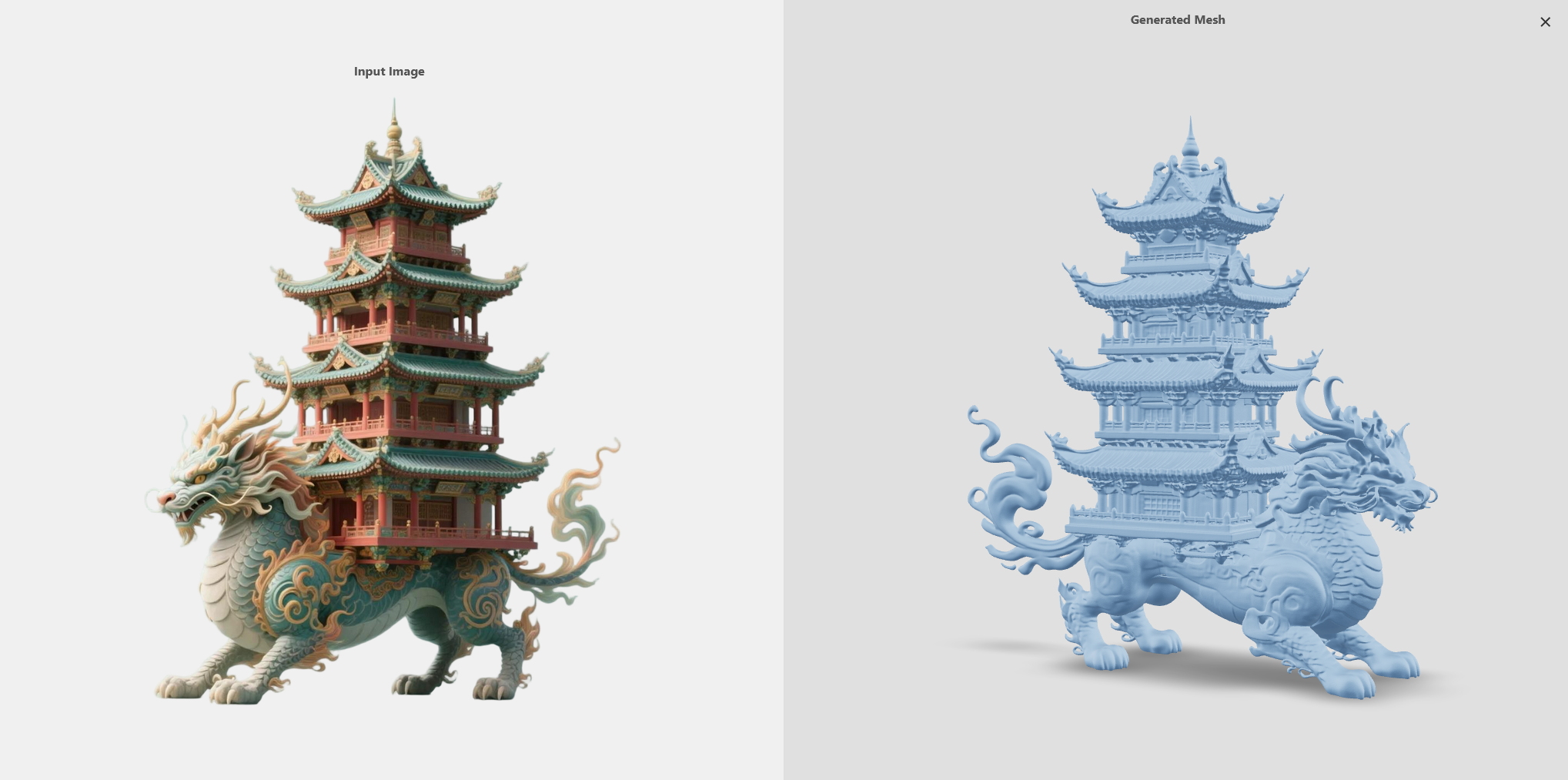

Hochauflösende 3D-Rekonstruktion mit UltraShape 1.0

Für 3D-Designer ist UltraShape 1.0 ein Durchbruch. Das Modell verwandelt einfache 2D-Bilder in hochdetaillierte 3D-Meshes. Im Vergleich zu früheren Modellen wie Trellis 2 zeichnet sich UltraSharp durch eine weitaus höhere geometrische Komplexität aus, insbesondere bei feinen Strukturen wie Haaren oder architektonischen Details.

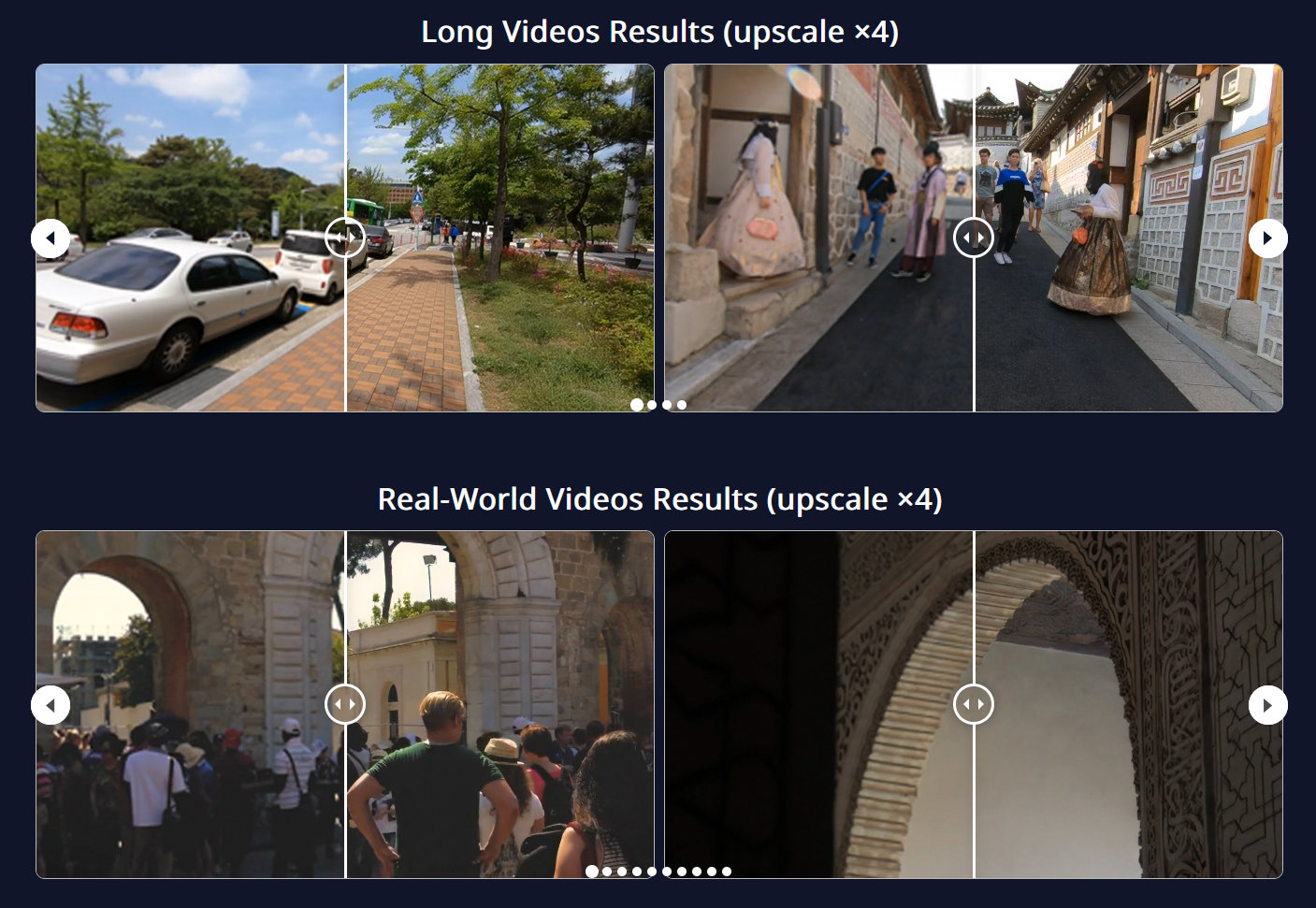

Beschleunigung und Upscaling: Die Zeit der Echtzeit-KI

Geschwindigkeit ist die Währung der modernen KI. Stream-DiffVSR demonstriert dies eindrucksvoll als Echtzeit-Video-Upscaler. Mit einer Beschleunigung, die das 15.000-fache herkömmlicher Methoden erreichen kann, lassen sich verpixelte Videos sofort in 4K-Qualität transformieren.

Zusätzlich hat Meta mit HighStream eine Methode vorgestellt, um Videogeneratoren wie Alibaba's Wan 2.1 um den Faktor 107 zu beschleunigen. Durch räumliche Kompression und „Anchor-Guided Sliding Windows“ wird Redundanz im Generierungsprozess eliminiert, was die Erstellung von KI-Filmen von Minuten auf Sekunden verkürzt.

Fazit und Ausblick

Die Entwicklungen dieser Woche zeigen einen klaren Trend: Die KI-Industrie bewegt sich weg von reinen Machbarkeitsstudien hin zu hochspezialisierten, effizienten Werkzeugen für den professionellen Einsatz. Ob es die stabilere Trainingstechnologie MHC (Manifold Constrained Hyperconnections) von DeepSeek ist oder die unglaubliche Geschwindigkeit von TwinFlow für die Bildgenerierung – die Barrieren für hochwertige digitale Schöpfungen fallen.

Für Entwickler und Unternehmen bedeutet dies, dass lokale Hardware wieder an Bedeutung gewinnt. Durch Quantisierung und effiziente Architekturen wie die von IQuestCoder rückt die Unabhängigkeit von teuren Cloud-APIs in greifbare Nähe. Es bleibt spannend zu beobachten, wie diese Werkzeuge in den kommenden Monaten die kreative Landschaft verändern werden.

Weiterführende Informationen und tiefere Einblicke in die vorgestellten Technologien finden Sie in der ausführlichen Video-Analyse von AI Search:

YouTube: DeepSeek is back, realtime upscaler, realtime 3D worlds...