Die künstliche Intelligenz schreitet voran, und die zweite Dezemberwoche 2025 wird als einer der entscheidenden Wendepunkte in die Geschichte eingehen. Wir erleben nicht nur inkrementelle Updates, sondern fundamentale Sprünge in der Modellarchitektur, der Videokontrolle und der autonomen Handlungsfähigkeit von Agenten. Von OpenAIs monumentalem "GDPval"-Durchbruch mit GPT-5.2 bis hin zu Alibabas physiktreuer Videokontrolle – die Grenzen des Möglichen wurden erneut pulverisiert.

Der Gigant erwacht: GPT-5.2 und die Eroberung der Wissensarbeit

Das dominierende Thema dieser Woche ist zweifellos die Veröffentlichung von GPT-5.2 durch OpenAI. Während die Versionsnummer nur wie ein kleines Update klingen mag, erzählen die internen Metriken eine völlig andere Geschichte. Wir bewegen uns weg von reinen Chatbots hin zu Systemen, die komplexe, mehrstufige "Knowledge Work Tasks" auf Expertenniveau bewältigen.

GDPval: Der neue Goldstandard

Lange Zeit war der Turing-Test das Maß aller Dinge, doch in der modernen KI-Ökonomie zählt vor allem eines: Kann die KI einen menschlichen Experten in seiner täglichen Arbeit schlagen? OpenAI hat hierfür den GDPval-Benchmark eingeführt, der 44 Berufe aus den neun wichtigsten Industrien abbildet.

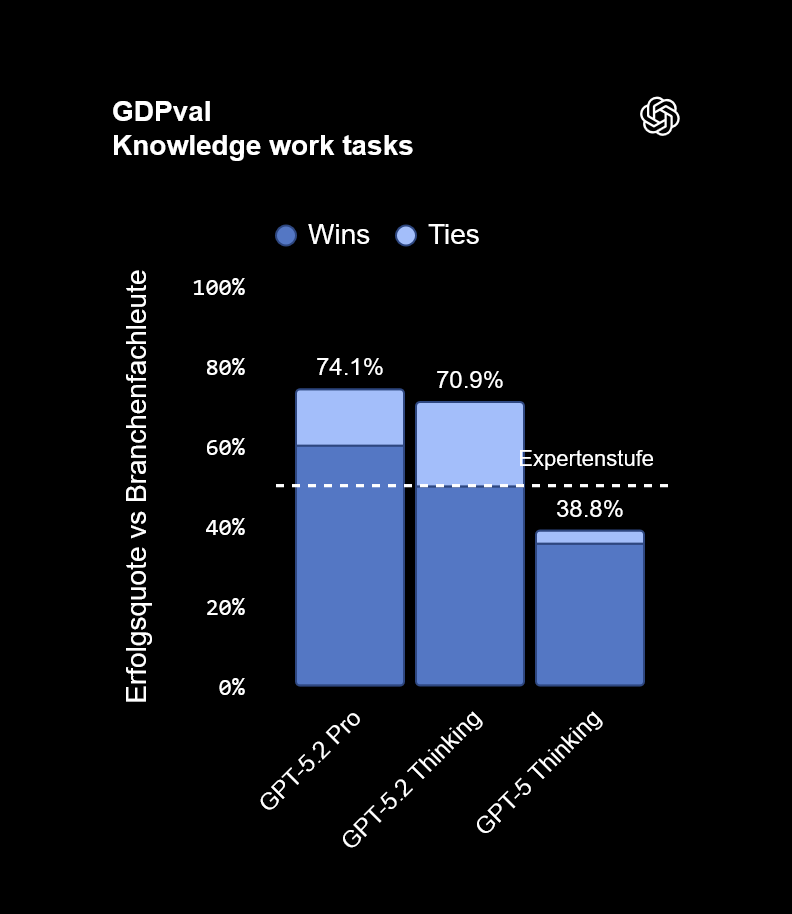

Die Ergebnisse sind schlichtweg atemberaubend. Während das ursprüngliche GPT-5 "Thinking" Modell noch Schwierigkeiten hatte, konsistent menschliches Expertenniveau zu erreichen (mit einer Erfolgsquote von nur 38,8%), hat GPT-5.2 diesen Wert fast verdoppelt.

Wie die Grafik verdeutlicht, erreichen sowohl die "Pro"- als auch die "Thinking"-Variante von GPT-5.2 Erfolgsquoten von 74,1% bzw. 70,9%. Das bedeutet konkret: In fast drei von vier Fällen liefert die KI ein Arbeitsergebnis ab, das dem eines erfahrenen Branchenprofis überlegen oder ebenbürtig ist. Das "Thinking"-Modell nutzt dabei eine dem menschlichen "System 2"-Denken nachempfundene Architektur, die es ihm erlaubt, vor der Antwort zu reflektieren, Strategien zu planen und Fehler selbstständig zu korrigieren, bevor der Output generiert wird.

Vom Chat zur Tat: Autonome Mobile AI-Agenten

Während OpenAI die kognitive Leistung in die Höhe schraubt, revolutioniert Zhipu AI (ZAI) die Art und Weise, wie KI mit unserer physischen digitalen Welt interagiert. Mit der Veröffentlichung von Open AutoGLM betritt ein Open-Source-Agent die Bühne, der das Versprechen des "Computer Use" endlich auf das wichtigste Gerät unseres Alltags überträgt: Das Smartphone.

Bisherige KIs waren in ihren Chatfenstern gefangen. AutoGLM bricht aus diesem Gefängnis aus. Es handelt sich um einen Agenten, der Ihr Telefon so bedienen kann wie Sie selbst: Er "sieht" den Bildschirm, identifiziert Buttons und Textfelder und führt Klicks und Wischgesten aus.

Ein echter Assistent, kein Chatbot

Die Implikationen sind gewaltig. Stellen Sie sich vor, Sie sagen Ihrem Telefon: "Finde das am besten bewertete Kino in der Nähe, kaufe zwei Tickets für die Vorstellung heute Abend und navigiere mich dorthin."

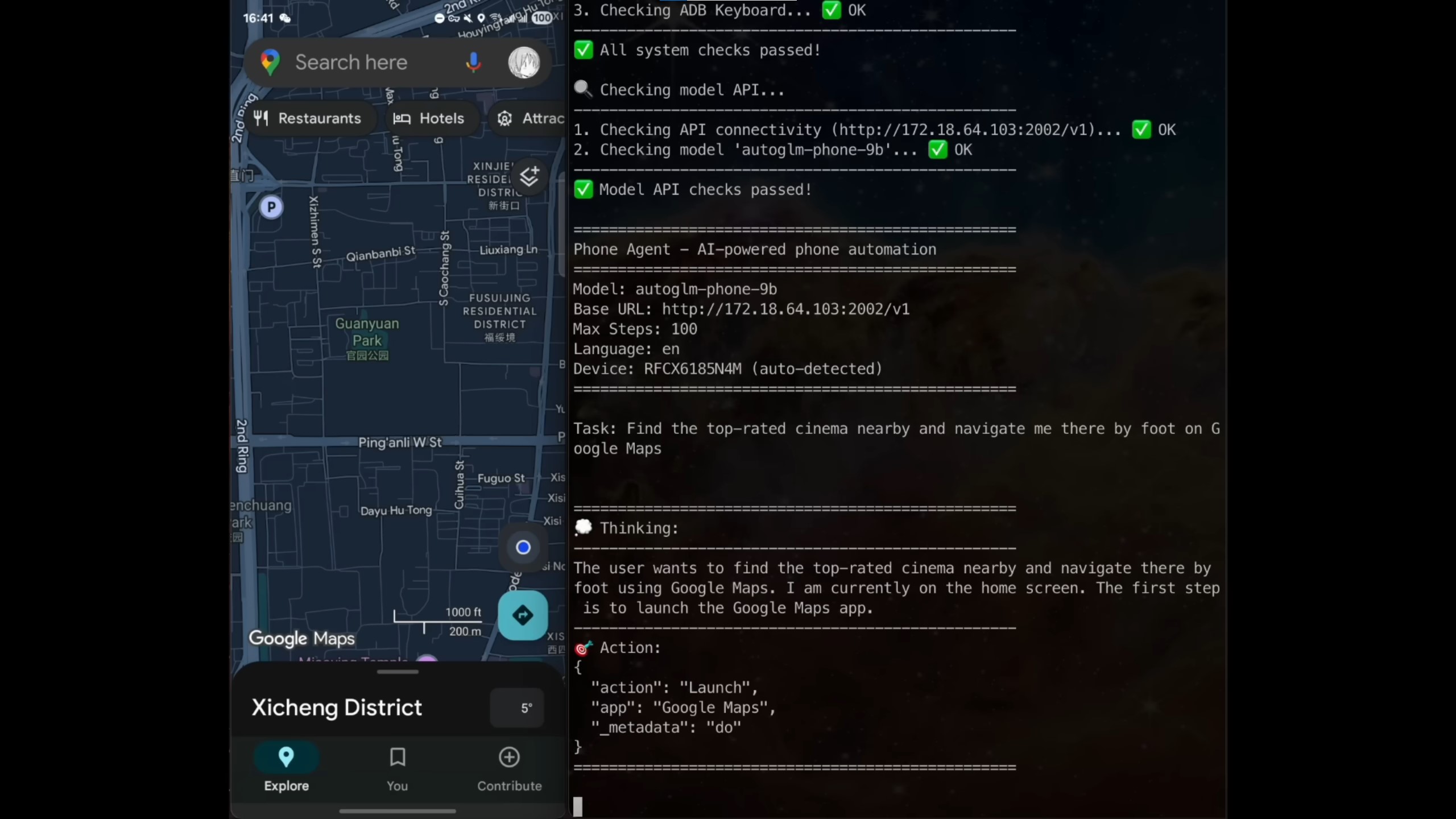

AutoGLM führt dies in einer Kette von Aktionen aus:

- Es öffnet die Browser- oder Kino-App.

- Es analysiert Bewertungen und Zeiten.

- Es interagiert mit dem Buchungssystem.

- Es öffnet Google Maps und startet die Route.

Das obenstehende Bild zeigt eindrucksvoll, wie das Modell (im Terminal rechts) den Befehl "Find the top-rated cinema nearby" in eine präzise Sequenz von Action: "Launch", "app": "Google Maps" und anschließende Tap-Befehle übersetzt. Besonders bemerkenswert ist, dass dieses Modell mit nur 9 Milliarden Parametern effizient genug ist, um auf Consumer-Hardware oder High-End-Smartphones zu laufen. Dies ist der Beginn der Ära, in der wir Apps nicht mehr selbst bedienen, sondern orchestrieren.

Die Revolution der Videokontrolle: Alibaba's Wan-Move

Im Bereich der generativen Videos haben wir lange Zeit unter dem "Lotterie-Problem" gelitten: Man gibt einen Prompt ein und hofft, dass die Bewegung im Video zufällig den Vorstellungen entspricht. Alibaba beendet dieses Glücksspiel mit Wan-Move.

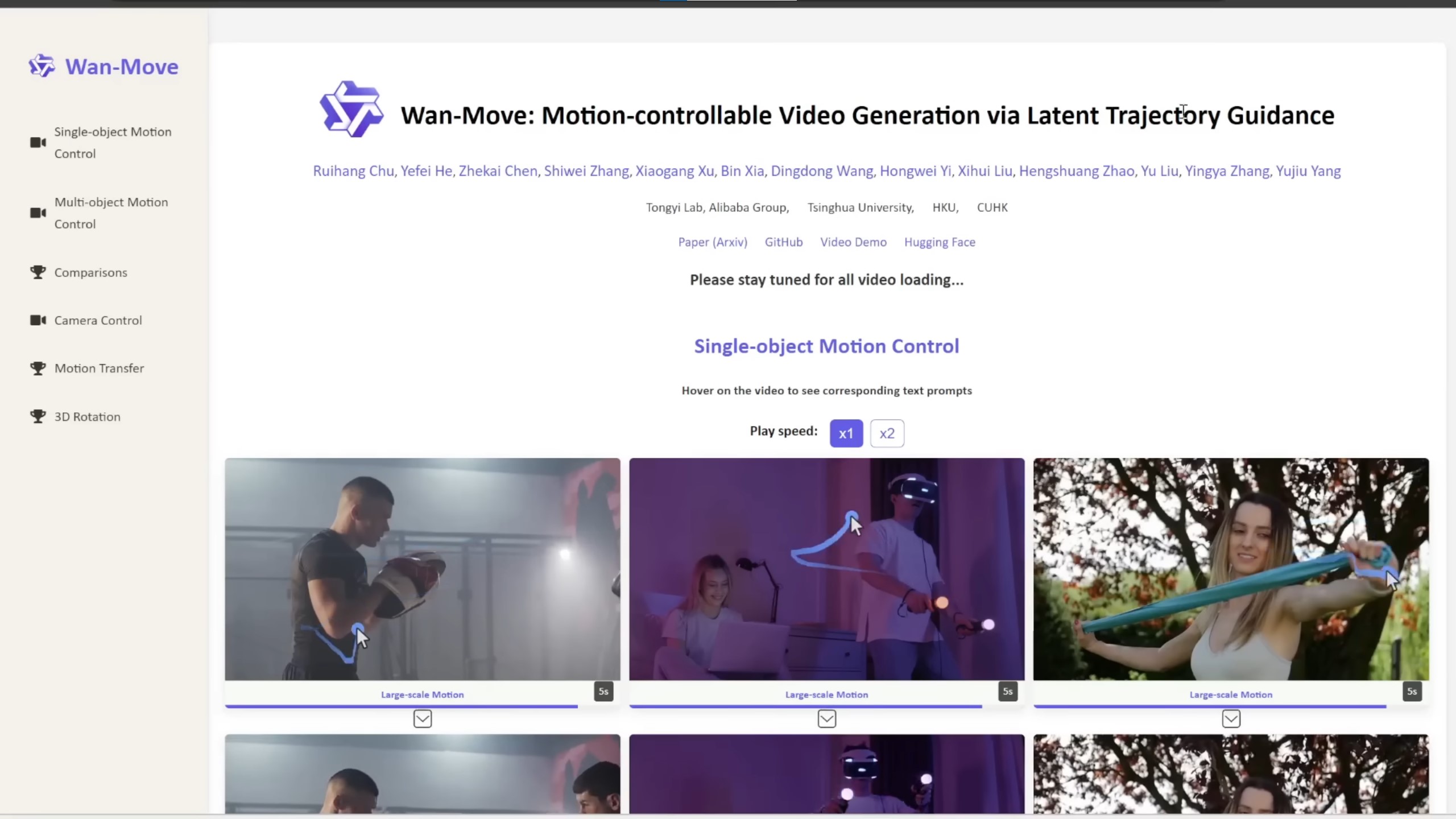

Wan-Move führt ein Konzept ein, das in der Fachwelt als "Latent Trajectory Guidance" bekannt ist. Anstatt nur zu beschreiben, was passieren soll, können Nutzer nun im Startbild Pfeile und Pfade einzeichnen, die exakt definieren, wie sich ein Objekt oder die Kamera bewegen soll.

Physik und Konsistenz

Die Demos sind verblüffend. Zeichnet man einen Pfad für eine Wasserflasche, die ausgegossen wird, versteht das Modell nicht nur die Bewegung, sondern simuliert physikalisch korrekt, wie die Flüssigkeit der Schwerkraft folgend in ein Glas fließt. Im Vergleich zu proprietären Konkurrenten wie Kling 1.5 Pro zeigt Wan-Move eine deutlich höhere Stabilität bei komplexen Bewegungen.

Ein besonderes Highlight ist die Trennung von Objekt- und Kamerabewegung. Sie können einen Charakter nach links laufen lassen, während die Kamera nach rechts schwenkt (Dolly-Effekt). Für Filmemacher und Content Creator bedeutet dies, dass KI-Video-Tools endlich den Schritt vom Spielzeug zum professionellen Werkzeug vollziehen. Da es sich hierbei oft um Open-Source-Initiativen oder zumindest offen zugängliche Papers handelt, sehen wir bereits Integrationen in Tools wie ComfyUI, was die Demokratisierung dieser Technologie beschleunigt.

Geschwindigkeit ist Qualität: Das TwinFlow-Phänomen

Während die Qualität der Generierung steigt, bleibt ein Nadelöhr bestehen: Die Rechenzeit. Diffusionsmodelle, die Technologie hinter MidJourney, Flux oder Stable Diffusion, funktionieren traditionell durch "Entrauschen" (Denoising) über viele Schritte hinweg. Das kostet Zeit und Rechenleistung.

Hier kommt TwinFlow ins Spiel, eine neue Methode, die verspricht, diesen Prozess radikal zu beschleunigen, ohne die Qualität zu opfern. Das Ziel ist die "One-Step Generation" – ein perfektes Bild in einem einzigen Rechenschritt.

Die Demokratisierung der High-End-Generierung

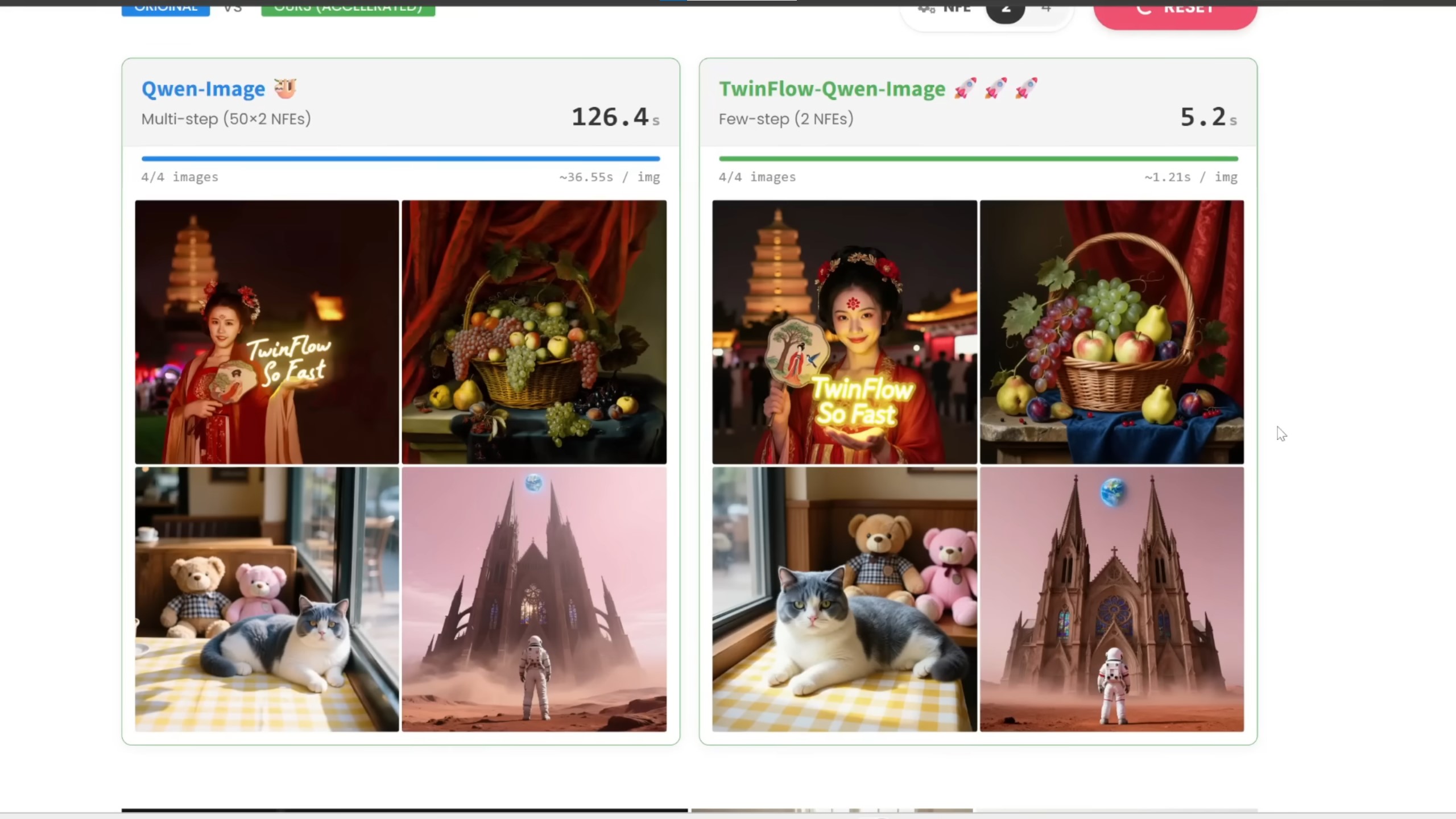

Wie im Vergleichsbild zu sehen ist, benötigt das reguläre Qwen-Image Modell für einen Batch von vier Bildern satte 126,4 Sekunden. Mit der TwinFlow-Optimierung sinkt dieser Wert auf unglaubliche 5,2 Sekunden. Das ist eine Beschleunigung um den Faktor 24.

Warum ist das wichtig? Weil es "Real-Time Creation" ermöglicht. Wenn ein Bild in einer Sekunde generiert werden kann, ändert sich der kreative Prozess. Feedbackschleifen werden eliminiert. Anwendungen, die dynamisch Inhalte für Videospiele oder VR generieren, werden plötzlich machbar. TwinFlow zeigt, dass wir nicht immer größere GPUs brauchen, sondern oft nur intelligentere Mathematik.

Weitere Highlights der Woche

Neben diesen vier Hauptthemen gab es eine Flut weiterer Innovationen, die den Rahmen sprengen würden, aber Erwähnung verdienen:

- WindowSeat: Eine KI, die spezialisiert darauf ist, störende Reflexionen aus Fotos zu entfernen, die durch Fensterscheiben aufgenommen wurden (z.B. im Zug oder Zoo).

- RealGen: Ein neuer Ansatz für fotorealistische Bilder, der einen "Detector Reward Mechanism" nutzt, um Artefakte wie zu glatte Haut ("Plastik-Look") aktiv zu bestrafen und so eine nie dagewesene Natürlichkeit erreicht.

- Mocha: Ein 3D-Generator, der Objekte nicht als einen soliden Block, sondern in ihren Einzelteilen generiert (z.B. Roboterarme separat vom Torso), was sie sofort animierbar macht.

- EgoEdit von Snapchat: Echtzeit-Videobearbeitung, die es erlaubt, Objekte im Live-Stream per Prompt zu verändern (z.B. wird eine Wasserflasche zu Lava).

Fazit: Die Konvergenz der Fähigkeiten

Was wir diese Woche sehen, ist keine isolierte Entwicklung, sondern eine Konvergenz. Wir haben Modelle, die denken können (GPT-5.2), Modelle, die handeln können (AutoGLM), Modelle, die unsere physische Welt verstehen und simulieren (Wan-Move) und Technologien, die das alles in Echtzeit verfügbar machen (TwinFlow).

Für Entwickler, Kreative und Unternehmer ist jetzt der Zeitpunkt, diese Werkzeuge nicht mehr nur zu beobachten, sondern tief in die Workflows zu integrieren. Die "Expertenstufe", die GPT-5.2 erreicht hat, ist keine Decke, sondern der neue Boden, auf dem wir bauen.

"AI never sleeps, and this week has been absolutely insane."

AI Search Channel

Bleiben Sie dran, experimentieren Sie mit den verlinkten Repositories (viele dieser Tools sind bereits auf Hugging Face verfügbar) und bereiten Sie sich darauf vor, dass das Tempo 2026 noch weiter anziehen wird.

Relevantes Video: GPT 5.2 & AI News Zusammenfassung

Dieses Video bietet eine detaillierte Zusammenfassung und visuelle Demonstrationen der im Artikel besprochenen Durchbrüche, einschließlich Benchmarks zu GPT-5.2 und Demos zu AutoGLM und Wan-Move.